OpenAIは、ローカルで実行可能な言語モデル「gpt-oss」シリーズを発表した。117B(1,170億)のパラメータを持つLLM「gpt-oss-120b」と21B(210億)のパラメータを持つSLM「gpt-oss-20b」の2種がAIモデル公開プラットフォームであるHugging Faceにて公開されている。

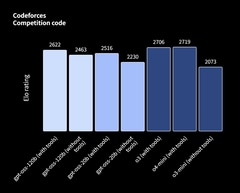

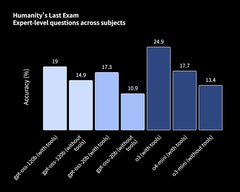

gpt-ossシリーズはローカルで動作可能なMoE言語モデル。gpt-oss-120bは80GBのVRAMを備えるGPU上で動作するとしており、これはNVIDIA H100上での動作を想定していると見られる。gpt-oss-20bは16GBのメモリで動作するといい、SNS上では既にGeForce RTX 4060 16GBやGeForce RTX 5060 Ti 16GBでの動作報告が挙がっている。主要なベンチマークにおいて、gpt-oss-120b、gpt-oss-20bはそれぞれ同社がクラウドで提供しているo4-mini、o3-miniと同等の性能を示すという。

OpenAIによるベンチマーク結果

OpenAIによるベンチマーク結果

gpt-ossシリーズは、OpenAIでは2019年リリースのGPT-2以来となるオープンウェイト言語モデルである。OpenAI CEOのSam Altman(サム・アルトマン)氏は2025年4月に「数カ月以内に新しいオープンウェイト言語モデルをリリースする」と予告しており、本リリースでそれが実現した形だ。適用されるライセンスはApache License 2.0で、無料で利用可能なほか、複製、改変、商用利用などが許可される。

OpenAIによれば、MicrosoftよりWindowsに最適化されたgpt-oss-20bがONNX Runtimeを通して提供されるという。

また今回のリリースに合わせ、o4-miniおよびGPT-4oに使用されているトークナイザのスーパーセットである「o200k_harmony」もオープンソースとして公開している。

WACOCA: People, Life, Style.