3年ぶりに東京開催のSIGGRAPH Asia 2024

コンピュータグラフィックスとインタラクティブ技術に関する世界最大の学会・展示会「SIGGRAPH Asia 2024」が、12月3日から6日までの4日間、有楽町にある東京国際フォーラムで開催されました。今回は世界中の30か国から9,000人近い参加者が集まり、内容ともども大変充実したイベントとして高評価でした。

今年のテーマは「Curious Minds(好奇心旺盛な心)」です。このテーマには、アーティストの創造的な作品から研究者による最先端技術の研究までのすべてが「好奇心」から生まれているという考えが込められています。

SIGGRAPH Asia 2024のビジュアルはGenerativeにアルゴリズムを活用して作られたもので、日本を基軸に世界で活躍されているデザインスタジオtakramによるデザインです。会期中は、丸の内の遊歩道が SIGGRAPH Asia 2024 の垂れ幕で埋め尽くされました。

基調講演、SONYが考えるAIと人間の創造性の共存

動画:https://www.youtube.com/watch?v=VPASKrgAQSE (全編、約50分)

ダイジェスト動画:https://www.youtube.com/watch?v=4q3XZ68Brl4 (日本語字幕つき約6分)

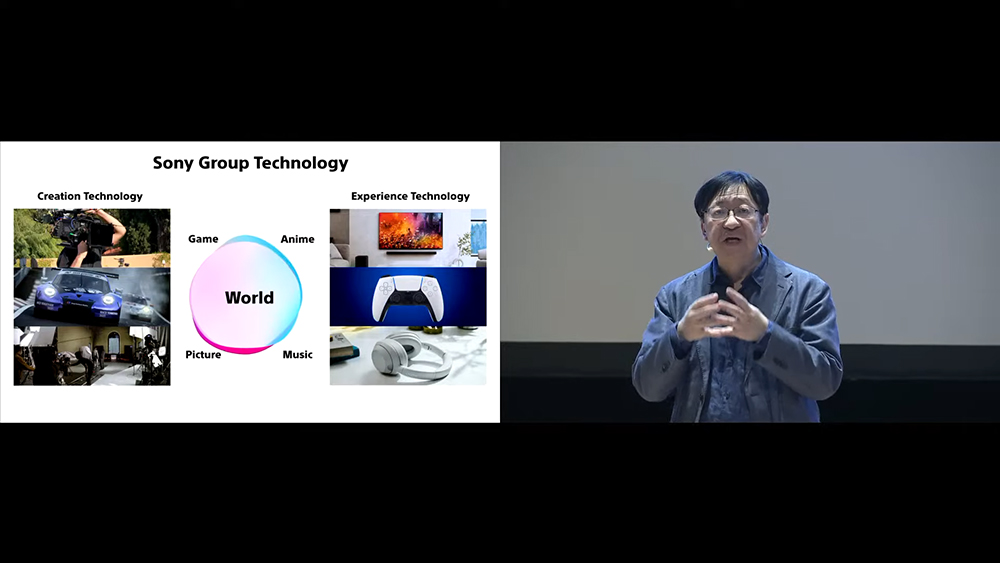

SIGGRAPH Asia 2024の3つの基調講演のひとつは、SONYのCTO北野宏明氏とSONYのグループ会社数社からのものでした。タイトルは「Co-Creating Worlds With Game Designers, Animators, And Filmmakers」、ちょうど2024年12月3日で30周年を迎えたSONY PlayStationの誕生を振り返りながら、技術と創造性の融合によりゲームデザイナー、アニメーター、映画制作者と世界を共に創造するという内容でした。

「世界を共に創り出す」その創造のプロセスでは、ユーザーが共感できるキャラクターやキャラクターを取り巻く環境、魅力的なストーリー、そしてユーザーとストーリーの関わりという四つの要素が鍵となるとのこと。これらのどれか1つが欠けても実現できず、4つの要素が融合することでユーザーを魅了する新しい世界を形作ることができると強調しました。

SONYが考える4つの要素

SONYが考える4つの要素

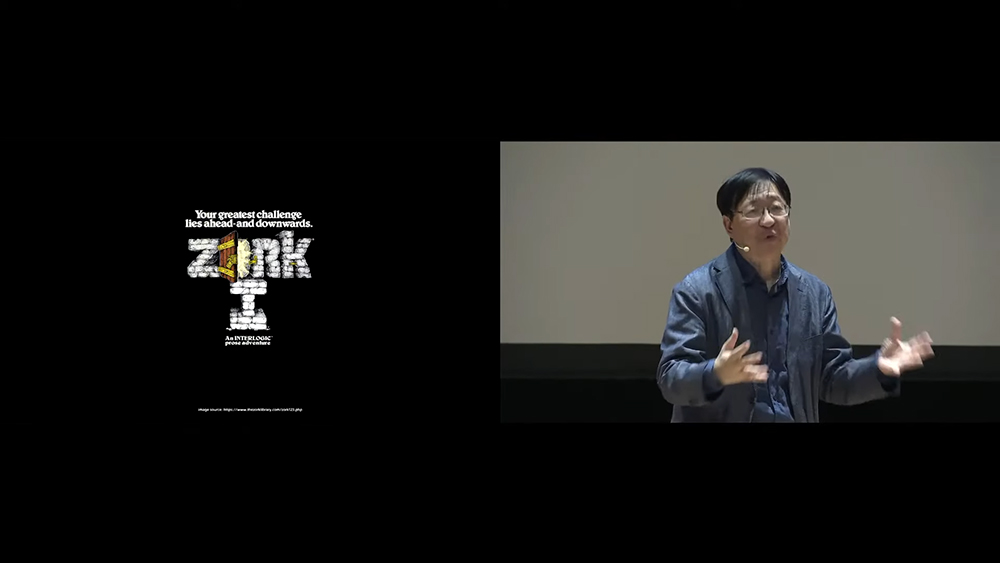

北野氏は、ご自身のコンピュータサイエンスとAIの研究者としての経験を交えながら、技術が創造性をどのように支えてきたかを紹介しました。1980年代に自然言語処理システムの研究に携わり、ZORKのようなテキストベースのアドベンチャーゲームに触発された経験が大きなきっかけとなり、ゲームの持つストーリーテリングの力をより深く理解するようになりました。

1980年代のテキストベースのアドベンチャーゲームZORKの起動画面

1980年代のテキストベースのアドベンチャーゲームZORKの起動画面

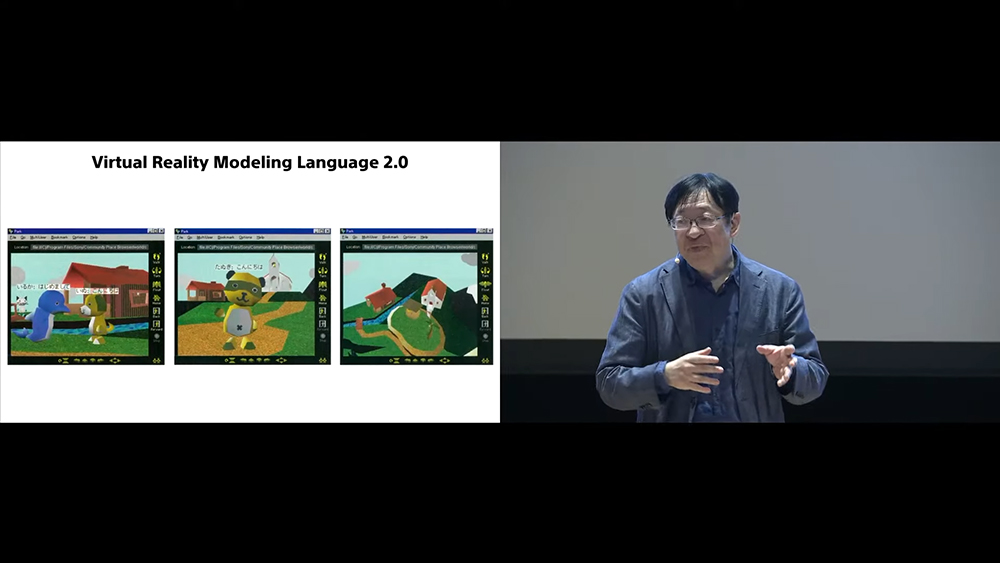

また、SONYで1990年代に取り組んだ初期プロジェクトVRML(Virtual Reality Modeling Language)を活用した「バーチャルソサイエティプロジェクト」を通じて、3Dの仮想社会の可能性を探求したことが後の技術進化につながったと述べました。この時に開発・検討された技術が現在の没入型エンターテインメントの基礎を築いたとのことです。

3Dインターネットの黎明期VRMLへの挑戦

3Dインターネットの黎明期VRMLへの挑戦

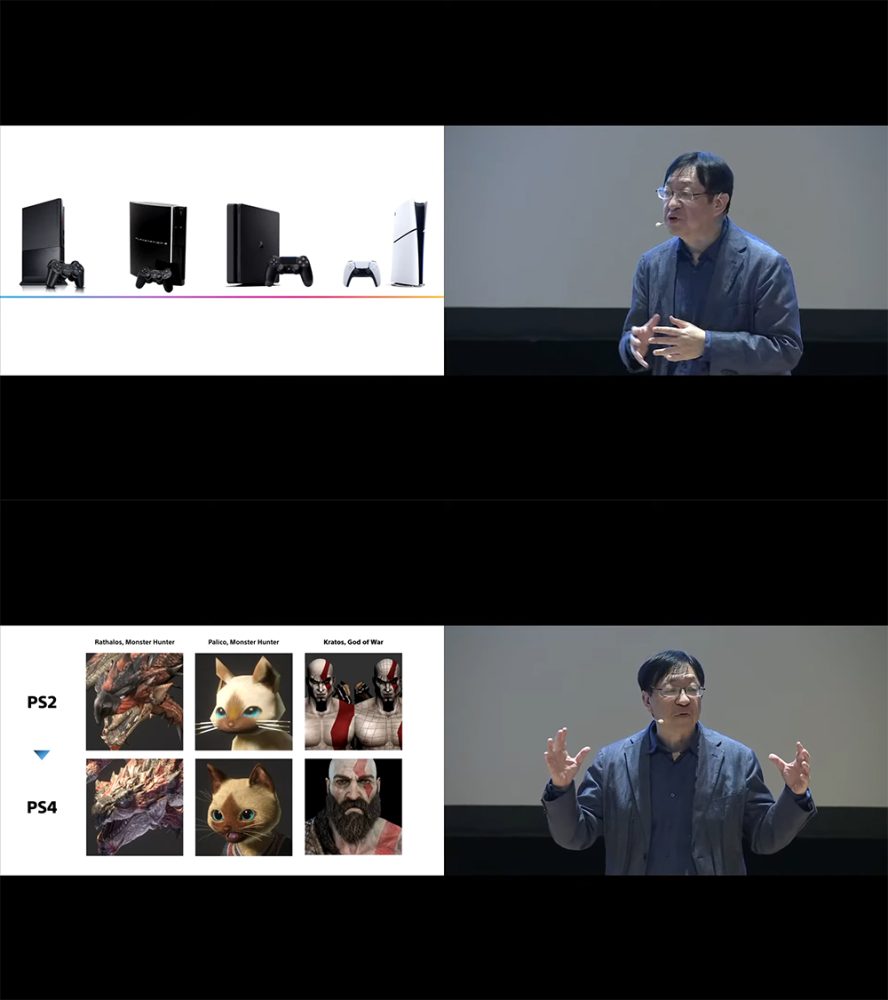

そして世界中で楽しまれているゲーム機、PlayStationがどのようにゲーム業界に変革をもたらしたかが語られました。初代PlayStationからPS5に至るまでの進化は、ゲームディベロッパーに創造の自由を提供し、グラフィックスやハプティクス(触感)技術の飛躍的な進歩を実現しました。特に初代作が1997年に発売されて以降、PlayStationの進化とともにバージョンアップしていったレースゲーム『グランツーリスモ』の進化をみながら、最新技術がどのようにリアリティを高め、プレイヤーの体験を変えていったのかが紹介されました。

PlayStation歴代機種と、表現力の進化

PlayStation歴代機種と、表現力の進化

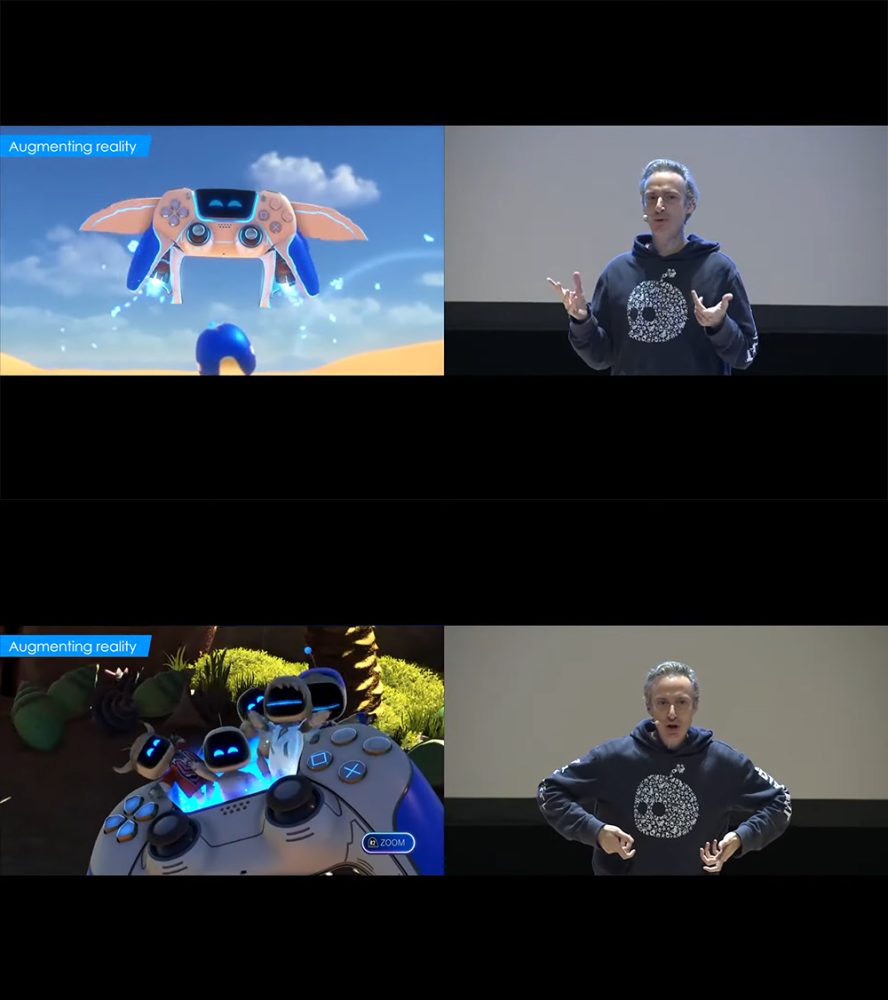

次にSONYの3人のクリエイターが登場し、それぞれの専門分野での取り組みを紹介しました。ニコラ・ドゥセ氏(Team ASOBI)は、最新作『アストロボット』の制作について語り、DualSenseコントローラーの「Techno Magic」によって新しい遊びの体験が実現されたことが紹介されました。

「Techno Magic」とは、DualSenseコントローラーの触覚フィードバックやモーションセンサーを活用し、プレイヤーがゲーム内で起きる現象を物理的に感じられるようにする工夫です。例えば、ゲームの中で雨の中を歩くと雨粒が肌に触れるような感覚が再現されるほか、特定のアクションに対して触覚フィードバックが反応し、ゲームへの没入感を高めてくれます。「Techno Magic」の技術は、触覚、視覚、音響の融合により、単なるゲームプレイを超えた人間の感覚に訴えかける没入感を提供しています。

DualSenseコントローラー

DualSenseコントローラー ゲーム中の画面内でDualSceseコントローラが乗り物になる様子と、コントローラーに搭載されているスピーカーからキャラクタの音声が聞こえ、ゲーム画面でも展開している様子

ゲーム中の画面内でDualSceseコントローラが乗り物になる様子と、コントローラーに搭載されているスピーカーからキャラクタの音声が聞こえ、ゲーム画面でも展開している様子

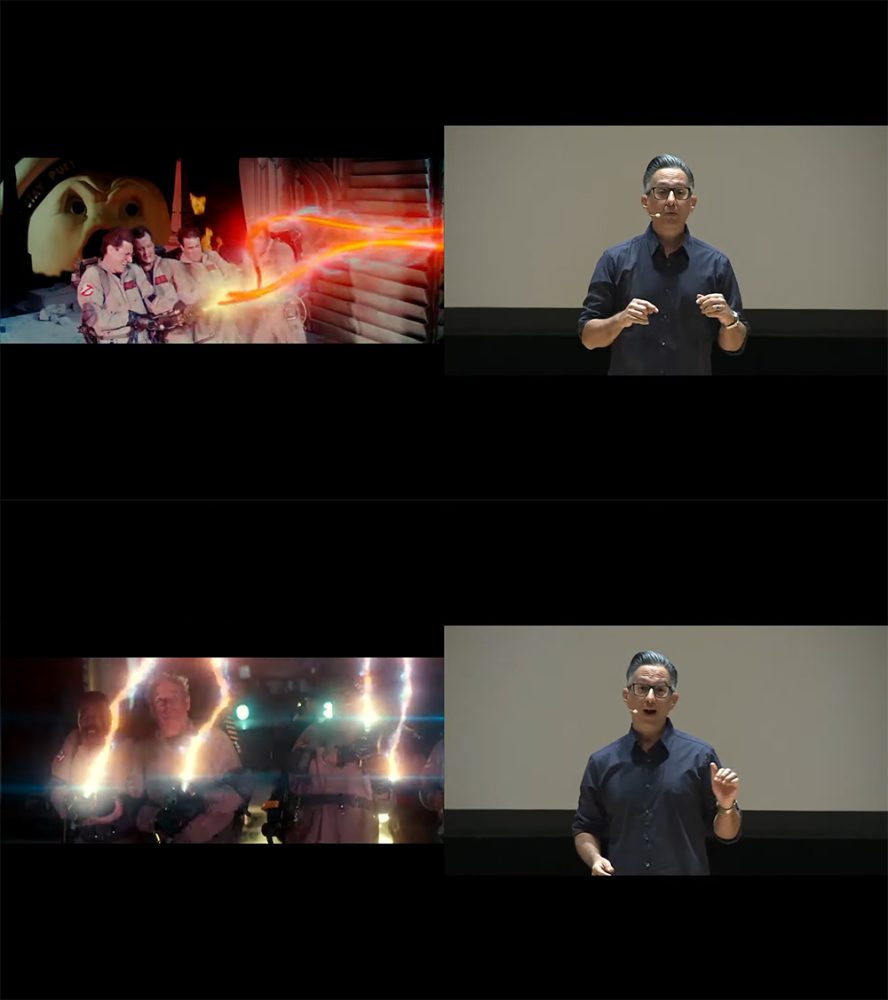

ベン・アギロン氏(SONYイメージワークス)は、『ゴーストバスターズ』や『スパイダーマン』でのVFXの活用事例について話し、80年代の視覚効果を現代技術で再現した制作の工夫を紹介しました。視覚効果とストーリーテリングの融合がどのように新しい表現を可能にしたのか、単なる派手なVFXではない思い入れが紹介されました。

『ゴーストバスターズ』の視覚効果の新旧の比較

『ゴーストバスターズ』の視覚効果の新旧の比較

レイ・ジャレル氏(Torchlight)は、ゲームエンジンであるUnreal Engineを用いたバーチャルプロダクションの革新について話しました。映画制作における効率化だけでなく、新しいツールや環境を手に入れることで、創造性を高められ、新たな表現技術が業界に浸透しつつあることが紹介されました。

バーチャルカメラやモーションキャプチャを駆使したTorchlightの製作現場

バーチャルカメラやモーションキャプチャを駆使したTorchlightの製作現場

今後AIがどのように創造性を高めているかについてはAIによるレースドライバー「グランツーリスモ ソフィー」の事例が特に会場参加者の注目を集めました。このプロジェクトはポリフォニー・デジタル社との協力により実現されました。このAIレーシングエージェントは、熟練した人間ドライバーと互角以上に競争する能力を持ち、ゲームプレイヤーに新たな走法への挑戦と習熟の機会を提供しています。

つまり、AIがゲームデザインそのものに新たな視点をもたらし、クリエイターが新しいルールやゲームの構造、車体性能などを試す際のシミュレーションツールとしても活用されています。

「グランツーリスモ ソフィー」のAIレーシングエージェントによるレースシーン

「グランツーリスモ ソフィー」のAIレーシングエージェントによるレースシーン

また、生成AIの進化により、クリエイターはコンセプトデザインやプロトタイプ作成の効率を飛躍的に向上させています。具体例として紹介されたのは、SONYのAIツールです。このツールによってアートワークの初期段階で提案を行い、クリエイターがアイデアをブラッシュアップするプロセスを加速させています。

そのおかげでクリエイターはより短時間で高品質な作品を生み出せるようになりました。このプロセスでは、AIが過去のデータを基に創造的な発想を提案し、それを人間が微調整することで、従来の制作手順では不可能だったスピードとクオリティを両立しています。

AIを活用した製作過程

AIを活用した製作過程

さらにSONYはAI倫理を重視し、AIがクリエイティブプロセスの補完的な役割を果たす一方で、クリエイター自身の創造性が中心にあるべきだと考えています。このような取り組みによって、未来のエンターテインメントがAIによって画一化したものとしてではなく、多様性と創造性に満ちたものとなることを目指しているとのこと。SONYは、世界中のクリエイターと共に、未来の可能性を探求し続けることを約束して、この基調講演を終了しました。

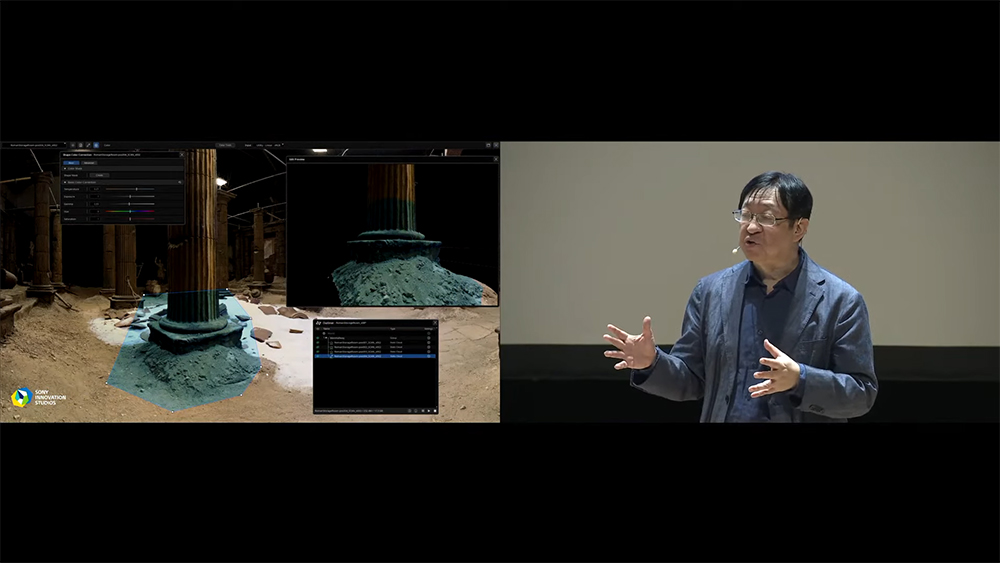

アニメ制作の現場でAIの可能性を探る。荒牧伸志監督が語るCGの可能性と課題

「Utilizing Generative AI for LookDev in CG Anime Production」は、CGアニメ制作におけるLookDevのためのジェネレーティブAIの活用です(LookDevとは質感や色彩、反射などの視覚的特性を調整する工程)。

荒牧監督は、自身の40年以上にわたるキャリアを振り返りながら、CGがどれほど映像制作の未来を変えてきたかを語りました。

ロボットや変形するバイクなど、メカデザインからスタートした荒牧監督のキャリアでは、アニメ特有の「作画崩壊」や動きの一貫性の問題を克服するためにCGに挑む転機を迎えているとのことです。

「CGのいいところは、形や動きを正確に再現できること、手描きだと崩れてしまうような要素も、3DCGなら安定します」と荒牧監督はコメントする一方で、CG特有の難しさもあるといいます。「人間らしい柔らかさや自然な揺らぎみたいなものがCGだとなかなか表現しにくい」といい、この「人間らしさ」をどう取り戻すかが、今回のプロジェクトの重要なテーマだったそうです。

CGを活用した制作に加えて、注目したのが生成AIの活用です。荒牧監督が「Beyond Quality(その先の品質)」と名付けたプロジェクトのテーマのもとで、生成AIをどのように活用していくかがチーム内で議論されました。1年前の試用段階では、生成AIでは制作の最終段階で動画の一貫性が保てなかったり、キャラクターの動きが不安定になったりする課題がありました。それを克服するために、生成AIを既存の3DCG制作フローに組み込み、AIが得意なところを活かしながら、苦手な部分は人間が補完する形をとりました。

CTOの高橋氏は、「生成AIを使うためには、まずクオリティを細かく言語化し、課題を細分化することが大事でした」と振り返りました。例えば、キャラクターの表情や口の動きといった細かい部分は、人間が手を加え、AIの出力だけに頼るのではなく、人の手を加えることでさらに良いものに仕上げるという方法で進めていったそうです。

生成AIを使った制作には、これまでとは違う工夫が求められました。それはAIが素材を認識しやすいようにデータを準備することが重要とのこと。影や輪郭を強調したり、AIが理解しやすい形に整えた素材を用意したりすることで、最終的な出力の精度が大きく向上したそうです。

また、荒牧監督が掲げた「Beyond Quality」という目標を実現するため、生成AIが得意とする部分と人間が必要な調整を行う部分を明確に分けたのもポイントでした。最終的には、従来のCGだけの制作よりも効率的で、かつ高品質な映像が完成したそうです。

次に話された東京大学松尾研の坂本氏は、AIの高速化と効率化についての考察です。AI技術は急速に進化しており、坂本氏は「生成AIを現場で使うには、ヒューマン・イン・ザ・ループが重要です」と強調しました。これは、人間が得た知見をAIにフィードバックすることで、AIがさらに精度を上げていくという仕組みです。

またOpenAIやGoogleなどの巨大AI企業と同じことをするのではなく、品質を上げるためにはコストがかかるが、限られたリソースで最大限の成果を出す工夫が必要だと述べ、創意工夫が技術革新を支える鍵になる持論を紹介しました。

最後に荒牧監督は、生成AIへの期待とは、思いつきもしなかった新しい表現を見せてくれ、テクノロジーが映像制作を次のレベルに引き上げることであると述べ、AIへの期待を込めた可能性を示唆して講演を終了しました。

AIが最大限活用されたSIGGRAPH Asiaの論文の数々

SIGGRAPH Asiaの論文は、多くの分野、ジャンルを包括していますが、その中から特に機械学習、人工知能をCG研究に応用したもの、活用したものをいくつか紹介します。

SIGGRAPH Asia 2024 論文ダイジェスト(約4分)

https://www.youtube.com/watch?v=hUktDm6WU6w

ベストペーパー(最優秀論文)は、Googleの研究者たちによる「Quark: Real-time, High-resolution, and General Neural View Synthesis」でした。

SIGGRAPH/SIGGRAPH Asiaの本分は学会でありトップカンファレンスと呼ばれ、採択されるのが難しい世界最高峰のCG分野の学会のひとつでもあります。今年は例年に比べとくに論文投稿数が多く40か国から合計899件、SIGGRAPH Asia 2024ではカンファレンス論文146件と 119 件の論文集からの採択されました。論文発表が行われた後、日本語でその分野の専門家が論文解説するセッションも連日満席になるほどの人気でした。

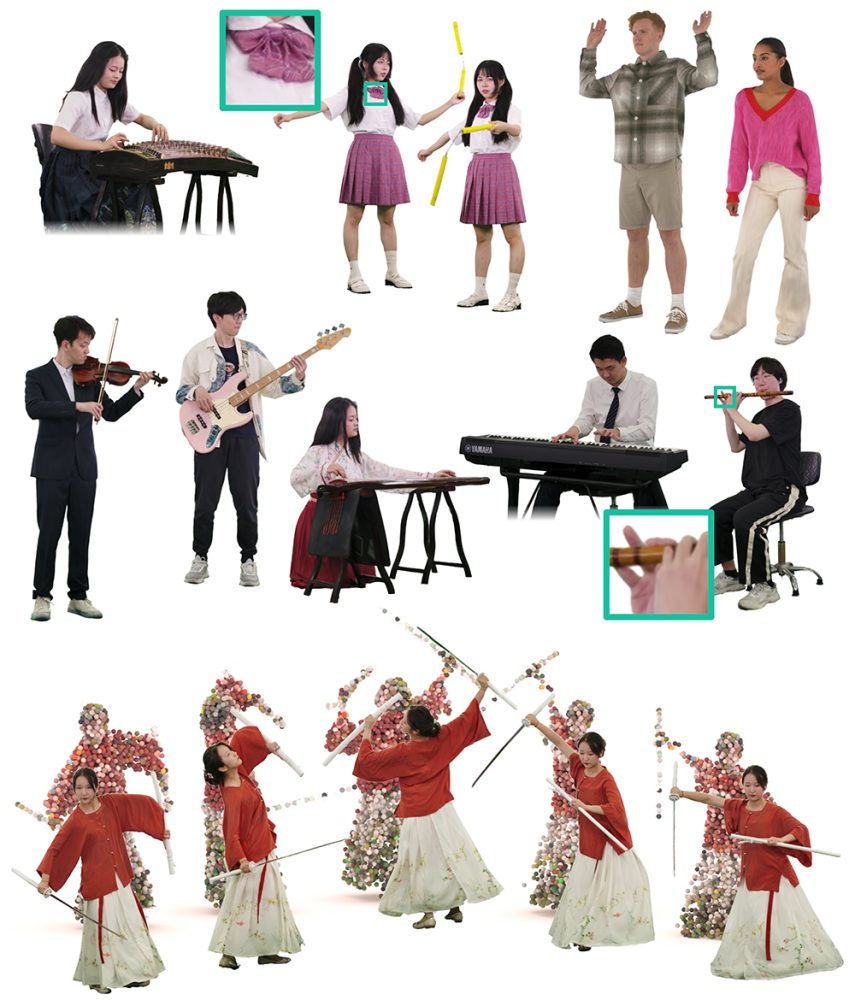

Robust Dual Gaussian Splatting for Immersive Human-centric Volumetric Videos(頑健な二重ガウススプラッティングによる没入型人間中心ボリュメトリックビデオ)

公式:https://nowheretrix.github.io/DualGS/

論文:https://arxiv.org/abs/2409.08353

新しい「デュアルガウススプラッティング」技術を用いて、没入型体験を大幅に向上させるボリュメトリック映像技術を提案しています。メタバースやバーチャルリアリティコンテンツの制作において、視覚的品質と計算効率の両立が期待されます。AIの活用としては、ニューラルレンダリング技術を利用して、動的なシーンをリアルタイムでキャプチャし、計算効率の高い方法で高品質なボリュメトリックビジュアルを生成しています。

Polarimetric BSSRDF Acquisition of Dynamic Faces(動的な顔の偏光BSSRDFの取得)

公式:https://vclab.kaist.ac.kr/publications.html

論文:https://vclab.kaist.ac.kr/siggraphasia2024/polar-face-main.pdf

偏光と光学モデルを使用して、動的な顔の表面特性をリアルタイムで正確にキャプチャする手法を提案しています。この技術は映画、ゲーム、さらにはリモート会議のアバター生成においても革新的な可能性を秘めています。機械学習モデルを使用して、偏光データを基に物理的に正確な反射・透過特性を推定し、顔の動きをリアルタイムで再構築している部分がポイントです。

※BSSRDF(Bidirectional Surface Scattering Reflectance Distribution Function):物体表面の反射特性を記述するモデル

A Generalized Ray Formulation For Wave-Optics Rendering(波動光学レンダリングのための一般化された光線の定式化)

公式:https://www.nvidia.com/en-au/events/siggraph-asia/

論文:https://arxiv.org/abs/2303.15762

光学レンダリングの新しい数理モデルを提示し、より現実的な波動光学効果を高速に計算可能にする技術です。物理的に正確なシミュレーションが求められる映像制作や光学設計分野での応用が期待されます。物理ベースの光学シミュレーションに機械学習モデルを統合し、現象を効率的に再現する新しいレンダリングアルゴリズムが用いられています。

Gaussian Surfel Splatting for Live Human Performance Capture(ライブ人間パフォーマンスキャプチャのためのガウシアンサーフェルスプラッティング)

公式:https://kkbless.github.io/

論文:https://drive.google.com/file/d/1PGigrWCZ0NkxPmBZ9CgUp6ZWgYe71Dhz/view

リアルタイムの人間のパフォーマンスキャプチャ技術で、エンターテインメントやVR/AR体験におけるインタラクティブなコンテンツの作成を大幅に簡素化。特に、自然な動作を高精度で記録するところがポイントです。ディープラーニングを使用して、キャプチャされた動きと表面特性をリアルタイムで処理し、ガウス分布により、高品質なオブジェクト表面の再構築を行います。

LLM-enhanced Scene Graph Learning for Household Rearrangement(家具再配置のためのLLM強化シーングラフ学習)

公式:https://davit666.github.io/AEG-rearrangement/

論文:https://arxiv.org/abs/2408.12093

動画:https://davit666.github.io/AEG-rearrangement/(ページ中央あたりに掲載)

大規模言語モデル(LLM)を活用して家庭環境における家具等の配置や再構成を最適化する手法を提案しています。スマートホームや家庭用ロボットのタスク計画における応用が期待されます。LLMを使用してシーングラフと呼ばれる物体の依存関係の構造把握を強化し、環境理解やタスク計画における精度を向上。複雑な環境での最適な物体配置や移動する場合の計画立案を支援しています。

Near-realtime facial animation by deep 3d simulation super-resolution(深層3Dシミュレーションで超解像度によるほぼリアルタイムの顔アニメーション)

公式:https://research.nvidia.com/labs/prl/publication/park2023nearrealtime/

論文:https://research.nvidia.com/labs/prl/park2023nearrealtime/facialsupersim2023.pdf

顔アニメーションのリアルタイム生成を深層学習技術で実現し、映画やゲームのキャラクター制作、さらにはリモートアバターの高精度化を促進します。特にディープラーニングを使用して全体の計算コストを抑えつつ高精度な結果を得られる点が画期的です。

MaskedMimic: Unified Physics-Based Character Control Through Masked Motion Inpainting(MaskedMimic: マスクされたモーション補完による統一された物理ベースのキャラクター制御)

公式:https://research.nvidia.com/labs/par/maskedmimic/

論文:https://arxiv.org/abs/2409.14393

動画:https://research.nvidia.com/labs/par/maskedmimic/assets/MaskedMimic.mp4

物理ベースのキャラクター制御を統一的に実現するための手法を提案しています。マスクされたモーション補完を活用し、複雑なアニメーションやゲームキャラクターの動きを自然に再現することが可能です。ディープラーニングによるモーション補完技術を利用し、欠損したモーションデータを補完するのがポイントで、物理ベースの自然な動きを生成することができます。

ラップバトルもAIの独壇場!

SIGGRAPH Asia 2024 最終日のイベント、ゲーム系のCGやサイエンティフィックビジュアライゼーションなど、リアルタイムで表現・表示するCGのデモ発表の場「Real-Time Live!」で、盛り上がりました。11の発表の中でも、観客の拍手喝采を浴び、BEST OF SHOW AWARD を受賞したのは、異なるリリック(意見)から言葉を生成し、さまざまな議論を行うラップバトル形式によるディベートシステム「Debate Generation System in Japanese Rap Battle Format」でした。キーワードを2つをAIに与えると、そのキーワードをテーマにAI同士がラップバトルを繰り広げます。デモの内容もそのAIが出力する言葉でも観客は多いに盛り上がり、AWARDの受賞も納得です。

次回のSIGGRAPH 2025は、カナダのCG産業の中心地であるバンクーバーで、8月10日から14日までの5日間にわたって開催されることが決定しています。これに続き、SIGGRAPH Asia 2025は、12月15日から18日までの4日間、香港で開催が予定されています。ネットでさまざまな情報が得られ、特にコロナ禍以降、オンラインイベントが一般的になってきました。

しかしながらまだ一般に商品として販売される前の最新技術を直接体験し、第一線で活躍するクリエイターや研究者との対面での意見交換によりアイデアや発想が触発されます。志を同じくする仲間との交流ができるSIGGRAPHのようなリアルイベントの価値はこれからますます重要なのかもしれません。

SIGGRAPH 2025 バンクーバー:https://s2025.siggraph.org/

SIGGRAPH Asia 2025 香港:http://asia.siggraph.org/2025/

本連載の今後の予定:「CGへの扉」では、単なるAIの話題とは少し異なり、CG/VFX, アートの文脈から話題を切り取り紹介していきます。映像制作の現場におけるAI活用や、AIで価値が高まった先進的なツール、これからの可能性を感じさせるような話題、テクノロジーの話題にご期待ください。何か取り上げて欲しいテーマやご希望などがございましたら、ぜひ編集部までお知らせください。

CGへの扉:

Vol.68:AIの価値はクリエイティブの試行錯誤の回数と速度

Vol.67:AdobeMAX 2024開催。生成AIの近未来「Sneaks」の驚き

Vol.66:偶然に任せない、生成AIにおける演出・調整の可能性

Vol.65:CGの祭典SIGGRAPH2024におけるAI活用の潮流

Vol.64:不祥事とは無縁、生成AIが生み出す広告映像の違和感

Vol.63:ライバル? いえいえ思想が違います。Google I/O、Apple WWDCにみるAI戦略の違い

Vol.62:AIによるフェイク画像さえも新しい表現方法に

Vol.61:AIの影響を受ける素材ビジネスの生存戦略

Vol.60:AIは世界を認識したのか? Soraが描き出す物理世界

Vol.59:生活に浸透するAI、身の回りの「弱い」AI

Vol.58:生成AIによる映画産業の業務の置き換えはどこまで可能か?

Vol.57:AIを活用したCG論文紹介 #SIGGRAPHAsia2023 より

Vol.56:ハリウッド映画の自動生成も間近か? AI動画の可能性

≫≫すべてのバックナンバーはこちらから

Contributor:安藤幸央

WACOCA: People, Life, Style.