今回は、ローカルLLMの実行ツール「Ollama」のフロントエンド、Alpacaを紹介します。

Alpacaとは

Ollamaに関しては第825回で紹介しました。そこではフロントエンドとして、Open WebUIを使いました。

もちろんOpen WebUIを使うのもいいのですが、Ollamaにはフロントエンドがたくさんあります。Ubuntuで動作するGUIフロントエンドはないかなと思って探してみたところ、Alpacaを発見しました(macOS向けがやたら充実している印象です)。

Alpacaは、Flatpakパッケージになっているので導入とアップデートが簡単で、PythonのGTK4バインディングを使用しているためUbuntuとの親和性もいいです。ただし、動作環境で注意点もあります(後述します)。

生成AIのフロントエンドにはプロプライエタリなライセンスのものもありますが、AlpacaはGPL-3.0であり、用途に制限を受けないというメリットがあります。生成モデルはその限りではありませんが、最近オープンソースAIの定義が公開されたため、今後に期待したいところです。

動作環境

Alpacaの動作環境は、今回は次のとおりとします。

Ubuntuのバージョンは24.04 LTSです。GPUはNVIDIAかAMDのディスクリートGPUを搭載していることとします。

理由ですが、筆者が確認したところではAlpacaはWaylandセッションでないとうまく動作しません。X.Orgセッションだとどうもエンターキーの扱いに難があるようで、候補ウィンドウに表示されている候補を確定できません。

第833回で紹介したように、24.10からNVIDIAのプロプライエタリなドライバーを使用していてもWaylandセッションがデフォルトになりました。24.04 LTSでも、筆者が確認したところでは「追加のドライバー」で「nvidia-driver-550」をインストールするとWaylandセッションが選択できるようになりました(図1)。22.04 LTSでもNVIDIAのプロプライエタリなドライバーでWaylandセッションを有効にする方法もありますが、より安定的に動作することが期待できる24.04 LTSとします。

図1 今回使用したのはバージョン550のドライバー

AMDのGPUを使用している場合はROCmを使用することになります。とはいえ、ROCmはもともとサポートしているGPUがごく一部で、このAlpaca(正確にはそのバックエンドのOllama)でも制限があります。具体的にはOllamaのサイトで掲載されているものだけです。筆者が所有するRadeon 6600 XTは非対応でした。内蔵GPUはいわずもがなです。

実はRadeon 6600 XTでもROCmを使用する方法はあります。それはわかっていたのですが、筆者宅にある最速のGPUがNVIDIAというのも釈然としないものを感じていたため、清水の舞台から飛び降りる思いでAMD Radeon RX 7800 XT Challenger 16GB OCを購入しました。しかしながら、執筆時点でのAlpacaの最新版である2.9.0(とその前の2.8.0)では、あろうことかROCmランタイムが認識しないというバグがあり、涙をのみました。

なお、Intelのディスクリート(外付け)GPUには非対応です。そもそも所有者が少ないですし、あまり大きな問題にはならないでしょう[1]。

[1] と、うちにある2枚のIntel製ディスクリートGPUを搭載したビデオカードをじっと見つつ。

インストール

それでは、Alpacaのインストール方法を紹介します。

NVIDIAのGPUを使用している場合は、事前にプロプライエタリなドライバーをインストールしておきます。

あとは通常のFlatpakパッケージのインストールと同じです。ランタイムのインストールは、詳しくは第720回で紹介していますが、端的には端末から次のコマンドを実行します。

$ sudo apt install flatpak gnome-software-plugin-flatpak

$ flatpak remote-add –if-not-exists flathub https://flathub.org/repo/flathub.flatpakrepo

インストールが完了したら、再起動してください。

再起動後、ログインして端末を起動し、次のコマンドを実行してAlpacaをインストールします。

$ flatpak install flathub com.jeffser.Alpaca

AMDのGPUを使用している場合は、次のコマンドも実行してROCmランタイムをインストールしてください。

$ flatpak install flathub com.jeffser.Alpaca.Plugins.AMD

動作確認

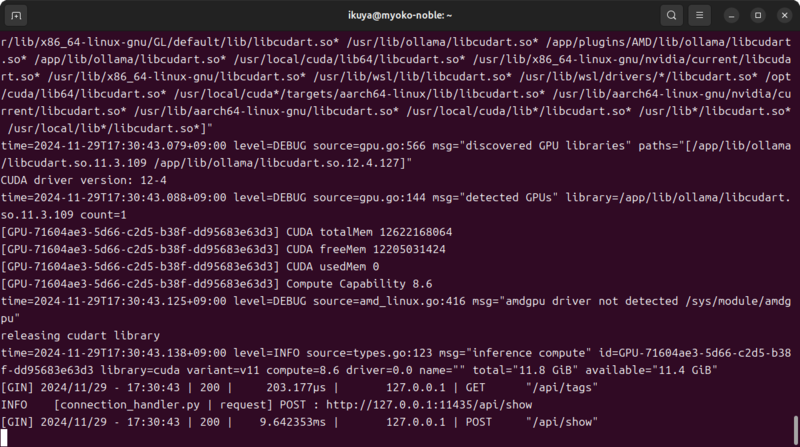

起動はもちろんアイコンから行ってもいいのですが、端末から起動するとデバッグメッセージが見られるため、こちらの方法を紹介します(図2)。

$ flatpak run com.jeffser.Alpaca

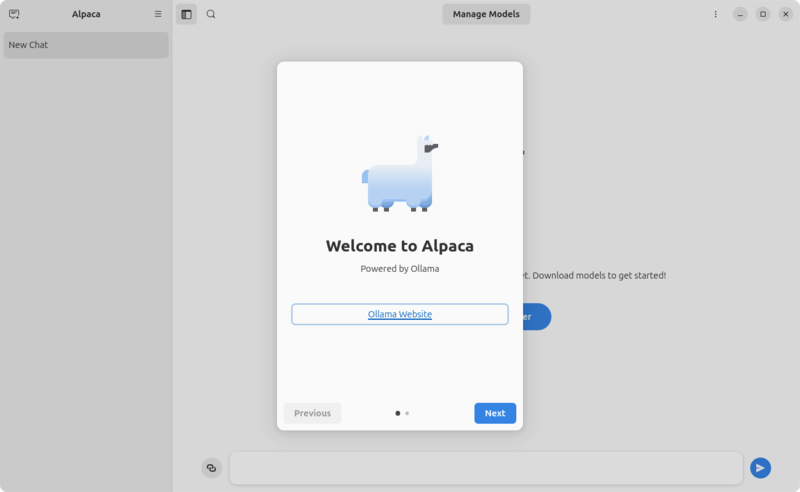

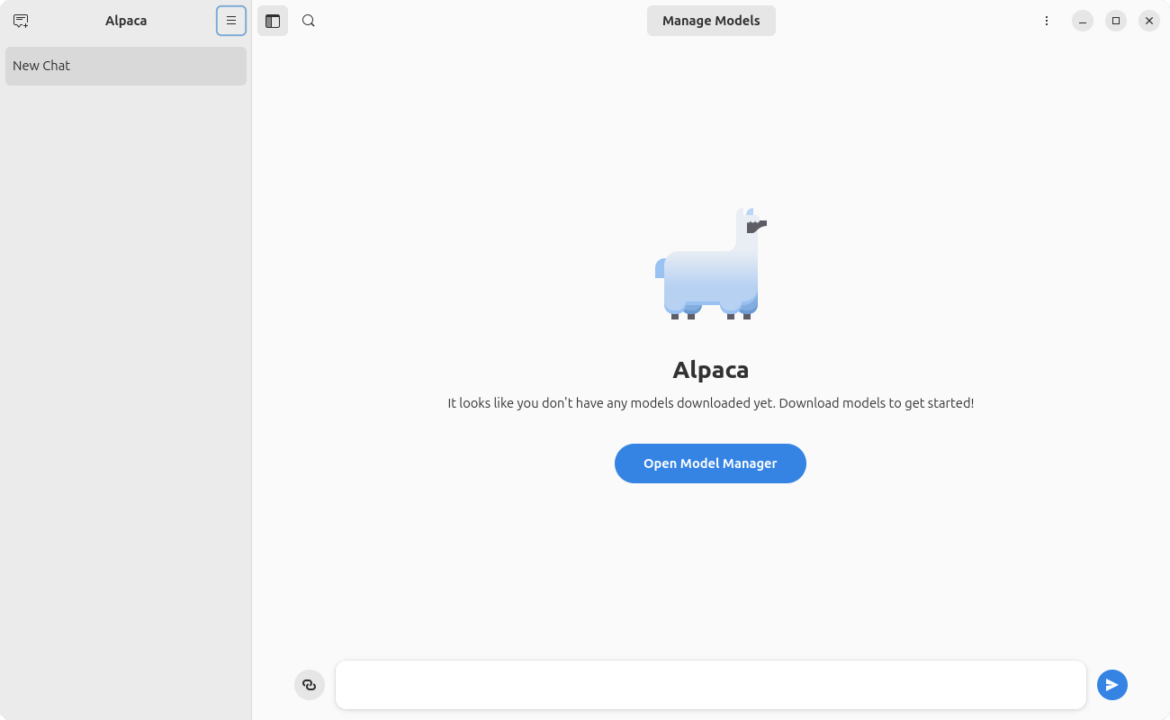

このコマンドを実行すると起動します(図3)。

図2 コンソールに表示されるデバッグメッセージ

図3 起動直後のAlpaca

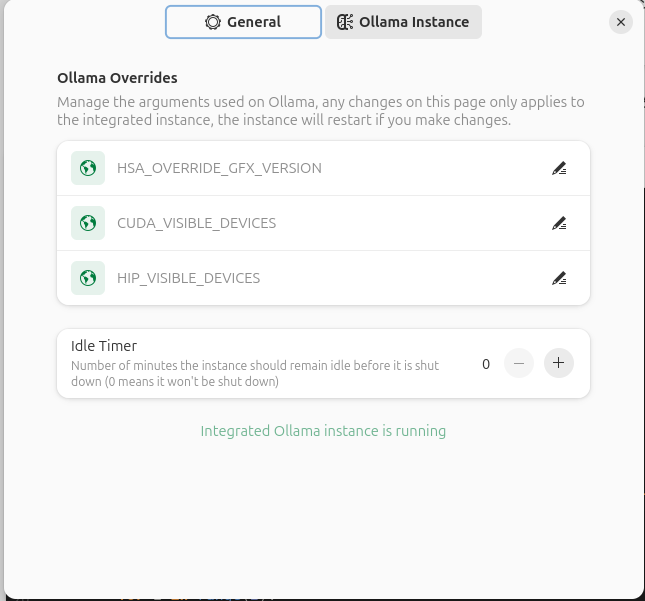

起動後、まずはハンバーガーメニューにある「Preferences」をクリックし、「Ollama Instance」タブを開いてください。最下行に「integrated Ollama instance is running」と表示されていれば、正しくGPUで動作しています(図4)。もし表示されていない場合は、根本的な原因はデバッグメッセージに記載されているので、そちらを確認してください。

図4 「integrated Ollama instance is running」と表示されていることを確認する

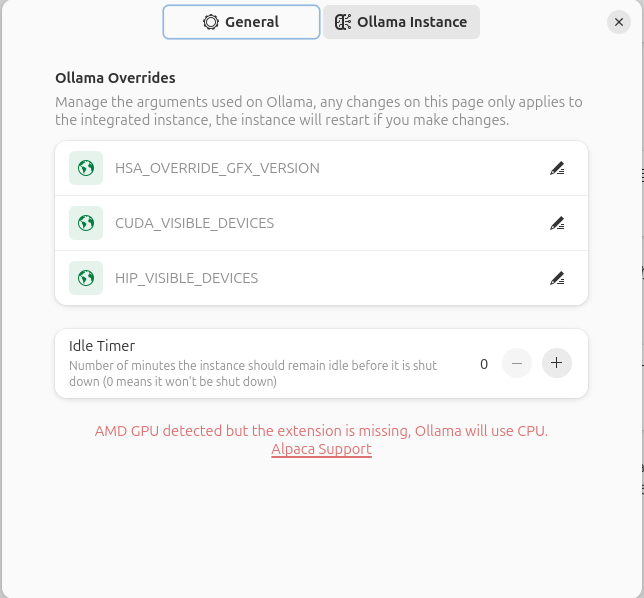

前述のとおり、少なくともAlpaca 2.9.0の段階ではAMDのディスクリートGPUだと認識しません。図5によると、別途インストールしたAMDのプラグインが認識できていないことがわかります。

図5 拡張機能(ROCmライブラリ)が見つからないのでCPUを使う旨の非情の通知

使用方法

Alpacaの使用方法は、モデルをダウンロードしていろいろなことを入力し、回答を得るだけです。

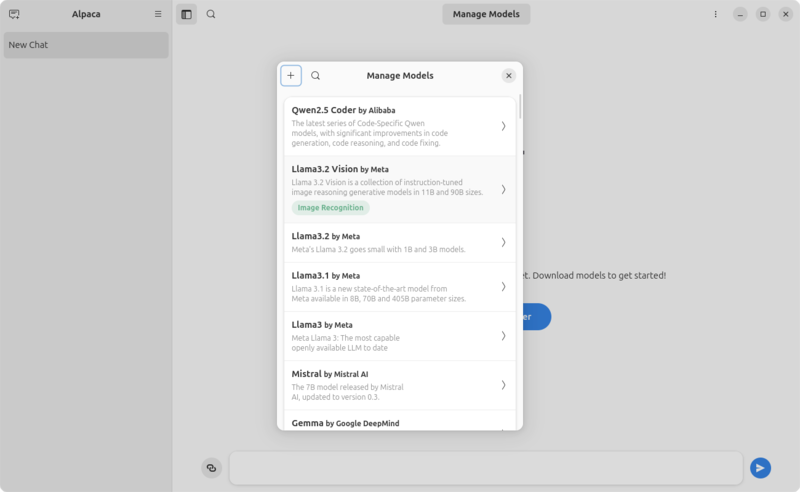

画面上部、あるいはハンバーガーメニューにある「Manage Models」をクリックして、モデルをダウンロードするメニューを表示します(図6)。

図6 「Manage Models」を開く

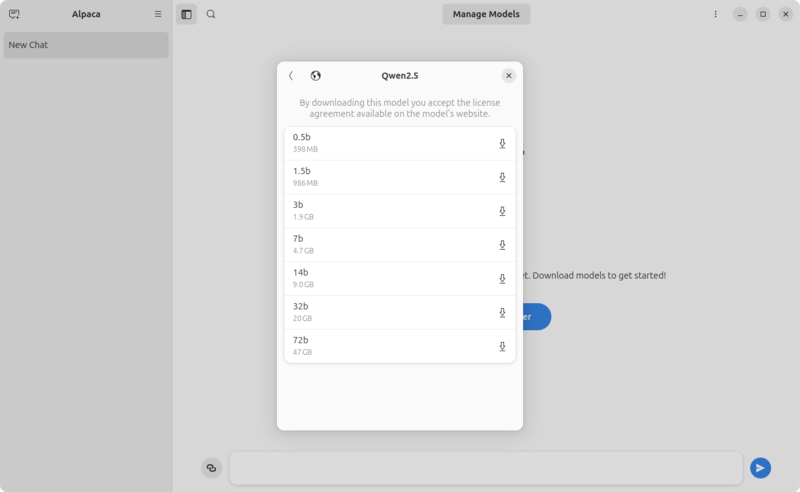

今回は筆者の個人的な好みで「Qwen 2.5」を使用します。Alibaba製のモデルで、14b以上であれば汎用性もあってコード生成にも使えて、なかなかいいのではないかと考えています。もちろんその分VRAMも必要で、8GBでは足りず12GB以上にしてください。

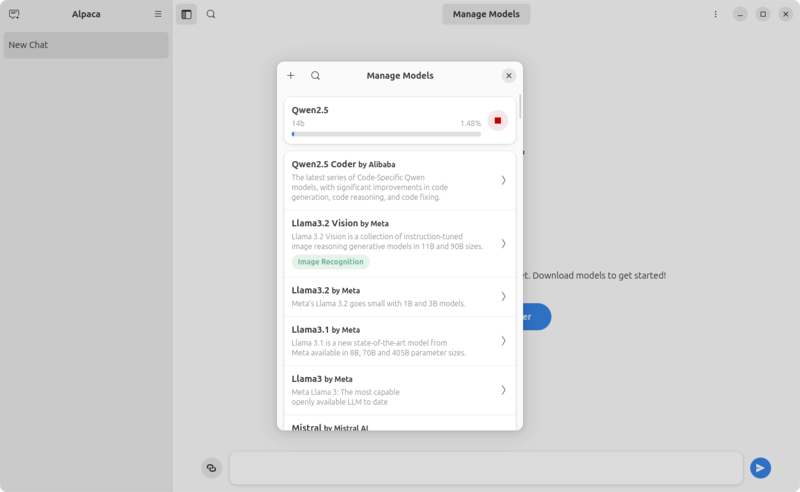

というわけで「Qwen 2.5」を開き、「14b」をクリックします(図7)。するとダウンロードが開始されます(図8)。

図7 Qwen 2.5のモデルがずらりと表示されている

図8 14bをクリックするとダウンロードを開始する

あとはじゃんじゃん質問していくだけです(図9)。

図9 中国企業のAlibaba製らしく最初は中国語で答えているが、日本語でもバッチリ回答してくれる

WACOCA: People, Life, Style.